L’intelligence artificielle Chat GPT fait l’actualité chaque semaine pour ses victoires en série face aux étudiants dans des examens universitaires. Alors que la presse est dithyrambique à son sujet tandis que d’autres s’inquiètent sur l’échec potentiel du cerveau humain face à une machine, à quoi peuvent réellement servir les « exploits » de cette IA et surtout quel est son coût pour notre société ? Nous publions ici un reportage de Juliette Duquesne, journaliste indépendante et créatrice du média Carnets d’Alerte, qui décortique le phénomène à l’aide de chercheurs spécialisés en AI.

« ChatGPT est incroyable, mais ça ne sert à rien ! » résume Daniel Goossens, chercheur en intelligence artificielle à l’université Paris 8 et auteur de bandes dessinées.

« C’est une prouesse mais pour quoi faire et à quels coûts ? », renchérit Nicolas Sabouret, docteur en intelligence artificielle, professeur en informatique à l’université Paris Saclay.

« Avec ChatGPT, on a passé une étape, mais pour quelle utilité ? », conclut Laurence Devillers, professeure en intelligence artificielle à Sorbonne université.

Depuis quelques semaines, les articles autour de ChatGPT ne manquent pas. Et comme à chaque fois, lorsque de nombreux médias traitent de l’intelligence artificielle, les exploits sont survendus. On aime se faire peur.

Le logiciel ChatGPT est-il si révolutionnaire ?

« Bluffant », « époustouflant », voici les mots utilisés par tous les chercheurs interrogés. Ils sont étonnés, sidérés par les résultats obtenus par ChatGPT-3.

« Nous avons testé un exercice d’algorithmes pour des étudiants en 1er année d’ingénieur, raconte Nicolas Sabouret. ChatGPT a mieux réussi que tous les étudiants. Il n’y a pas mieux pour intégrer les données et les synthétiser ».

Cependant, les spécialistes m’ont tous confirmé qu’il n’y avait aucune rupture technologique. Cette intelligence artificielle fonctionne grâce aux fameux réseaux de neurones. Nous sommes loin d’une intelligence artificielle forte, autonome.

« Ce sont des modèles de langage entraînés par un apprentissage profond sur une très grande base de textes. Ces modèles comportent un nombre de paramètres assez vertigineux : entre 100 et 1000 milliards de connexions », détaille Jean-Gabriel Ganascia, spécialiste en intelligence artificielle, professeur d’informatique à la faculté des sciences de Sorbonne université.

« La grande force est que ChatGPT est entraîné sur une quantité de données gigantesque, astronomique : pratiquement tout internet ! », ajoute Nicolas Sabouret.

En plus d’être entraîné sur un nombre considérable de données, l’autre nouveauté de ce logiciel créé par OpenAI est d’être multifonctionnel.

« Le coté enthousiasmant est qu’il est multitâche, précise Laurence Devillers. Il peut écrire un poème, répondre à une question… Il réussit à détecter la tâche. »

Une illusion dangereuse

Ce programme fait illusion mais il ne reproduit pas la compréhension humaine et réalise de nombreuses erreurs. Comme les autres programmes d’intelligence artificielle, il comporte de nombreux biais.

« OpenAI ne prétend pas que ChatGPT ne fait pas d’erreur mais celles-ci sont difficiles à détecter, d’autant qu’elles sont énoncées sur un ton péremptoire », explique Nicolas Sabouret.

Daniel Goossens s’est amusé à faire plusieurs essais avec ChatGPT. Il précise que ChatGPT donne toujours des réponses « bienveillantes », « politiquement correctes » :

« J’ai demandé à ChatGPT : est-ce que tu connais le prénom de Gotlib ? Il me répond : « Gotlib est le pseudonyme de Marcel Gotlib, un dessinateur et scénariste de bande dessinée français qui est né le 7 février 34 à Paris et qui est décédé le 8 juillet 2016. Il est surtout connu pour ses travaux dans le domaine de la bande dessinée humoristique. Il a contribué à la création de nombreux personnages et histoires célèbres. Gotlib est également connu pour son travail en tant que réalisateur de films et de télévision, ainsi que pour son activisme politique ». Or, Gotlib n’avait aucun activisme politique. Je lui demande donc : de quel activisme politique s’agit-il ? Il répond : « Gotlib était connu pour son engagement en faveur de causes politiques progressistes et de l’égalité des droits. Il a notamment soutenu les mouvements pour les droits civiques et les droits des femmes, ainsi que pour la paix et la justice sociale. Il a été également actif dans le mouvement pour les droits des animaux, il a soutenu de nombreuses causes environnementales ». On ne sait pas où il est allé chercher ça. Il raconte n’importe quoi ! »

« Le problème est que ChatGPT peut raconter n’importe quoi avec une syntaxe parfaite. »

Difficultés avec la négation, problèmes pour distinguer les séquences paires et impaires, dans cet article de The Conversation, Fabian Suchanek et Gaël Varoquaux détaillent les limites techniques et concluent :

« nous souhaitons montrer qu’il reste à l’heure actuelle imprudent de s’appuyer sur un modèle de langage pour raisonner ou prendre des décisions. »

Il est encore délicat de connaître tous les usages néfastes possibles de ce programme. Sciences Po l’a déjà interdit à ses élèves. Cet outil peut, bien sûr, être utilisé pour fabriquer du contenu, des fake news. A l’heure où tout doit être liquide, comme sur les marchés financiers (lire cet article pour en savoir plus), les plateformes ont besoin de contenu pour proposer de la publicité ciblée. Un tel programme peut être une aubaine.

Comme pour chaque avancée technologique, nous évaluons ses conséquences après la généralisation de son usage.

Laurence Devillers rappelle qu’une réglementation au niveau européen est en cours d’élaboration. Elle souhaiterait que les chatbot dont ChatGPT soient classés en IA à haut risque. L’objectif serait de mettre en place une procédure de validation des algorithmes.

« Nous pourrions imaginer une procédure comme pour les médicaments mis sur le marché avec les effets indésirables précisés », ajoute Philippe Besse, mathématicien, professeur émérite à l’Institut national des sciences appliquées (Insa) de Toulouse.

Cette procédure de validation pourrait exiger de préciser le taux d’erreur pour chaque programme d’IA.

Une opacité dérangeante

ChatGPT manque de transparence. Ces algorithmes collectent nos données en nombre considérable, des données envoyées aux États-Unis, où la réglementation est bien moins stricte qu’en Europe.

Autre opacité : le nombre d’êtres humains derrière cette intelligence artificielle. Comme nous l’avions montré dans l’ouvrage « L’humain au risque de l’intelligence artificielle » une multitude de petites mains – de la Chine au Burkina Faso – permettent à l’intelligence artificielle de fonctionner en étiquetant, en répertoriant les données et en identifiant les images.

Elles sont indispensables à différentes étapes, de la préparation des données à l’entraînement de l’algorithme. Ces travailleurs sont souvent exploités et très mal payés. Un article du Time a montré que cela était également le cas pour ChatGPT au Kenya.

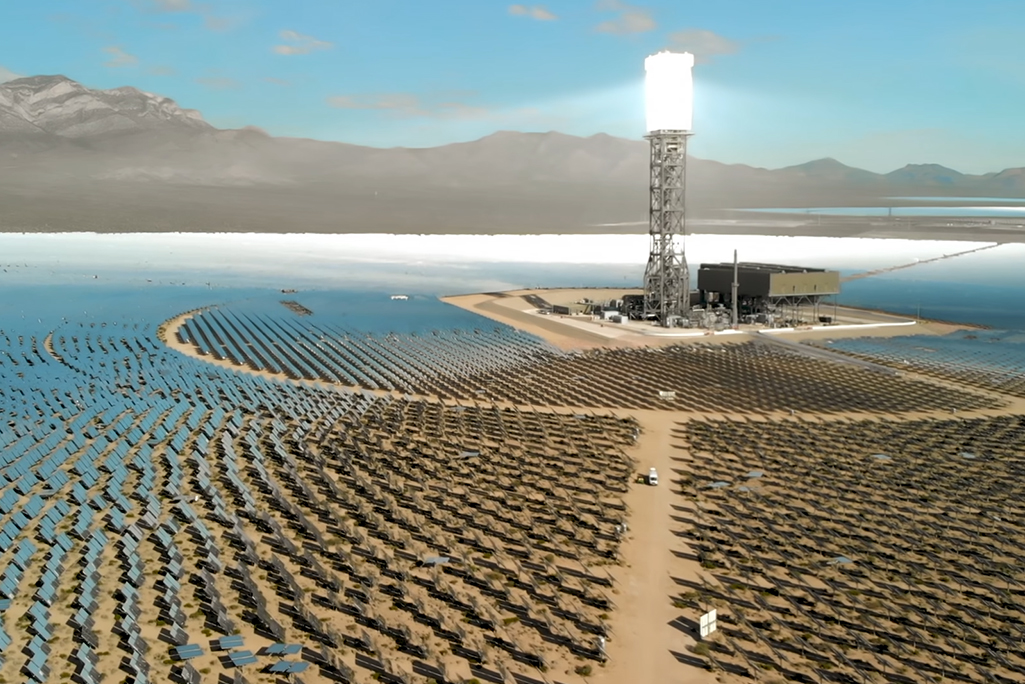

Le coût écologique considérable

Concernant l’intelligence artificielle, la partie la plus polluante est l’entraînement de l’algorithme lors de la phase de création d’un programme.

« Actuellement, de nombreux chercheurs de tous domaines utilisent des réseaux de neurones profonds car ils sont à la mode, mais ils n’ont parfois pas la quantité de données suffisante afin que le résultat soit considéré comme pertinent et robuste, regrette Emmanuelle Frenoux, maîtresse de conférences à Polytech Paris Saclay. Cela pose un problème scientifique et écologique. Plus le réseau est profond, plus il sera nécessaire de l’entraîner longtemps, plus il faudra de la puissance de calcul et le fonctionnement de machines en parallèle. Dans les années 2010, nous entraînions nos réseaux profonds sur nos propres machines. En 2021, nous avons un centre de calcul en face du laboratoire. On peut envoyer l’entraînement des algorithmes directement vers le centre de calcul et continuer à travailler sans même s’apercevoir du temps de calcul. »

La demande de puissance de calcul en IA double tous les trois ou quatre mois. Elle a été multipliée par 300 000 entre 2012 et 2018.

Une étude a montré que les émissions pour la phase d’entraînement d’un modèle sont comprises entre 18 kg d’équivalent CO2 et 284 tonnes d’équivalent CO2. Le modèle le plus couramment utilisé émet 652 kg d’équivalent CO2, soit environ un aller Paris-Hong Kong en avion, ou 2 500 kilomètres en voiture, sans même compter l’impact environnemental de la fabrication des machines pour entraîner ces algorithmes.

Je n’ai pas encore réussi à obtenir le chiffre précis de la dépense énergétique de ChatGPT. Entraîné sur une quantité gigantesque de données, il émet forcément beaucoup plus de CO2 que ce modèle.

ChatGPT et son accueil au sein de nos sociétés sont révélateurs de notre fuite en avant technologique. Pourquoi ne pas débattre de l’intérêt de telle ou telle avancée avant sa généralisation ?

Aujourd’hui, nous investissons des milliards d’euros dans l’intelligence artificielle, sans réfléchir aux risques écologiques et sociaux de ces technologies. Ces décisions devraient résulter de débats sociétaux.

Dans le monde actuel, limiter les usages numériques est loin d’être simple, d’autant plus que les États entretiennent des relations particulièrement proches avec les multinationales de la technologie. Cette croyance en une technologie remède à tous nos maux est particulièrement ancrée dans nos sociétés.

Juliette Duquesne, fondatrice du média Carnets d’Alerte

Retour

Retour